|

Lenovo Compute Orchestration в центрах обработки данных HPC с Slurm

3, март 2023 — Авторы : Ана Иримиа (Ana Irimiea), Victoria Hobson Введение Lenovo и SchedMD предлагают полностью интегрированное , простое в использовании , тщательно протестированное и поддерживаемое решение для оркестрации вычислений для всех серверов Lenovo HPC ThinkSystem. Этот краткий обзор решения содержит важную информацию для понимания ключевых функций и преимуществ оркестрации рабочих нагрузок HPC и ИИ с помощью Slurm с помощью Lenovo Intelligen t Computing Orchestration (LiCO). Этот документ предназначен для системных администраторов и пользователей HPC, продавцов HPC и руководителей центров обработки данных . Slurm Workload Manager — отличный инструмент для решения задач , с которыми сегодня сталкиваются центры обработки данных высокопроизводительных вычислений : автоматизация процессов , а также оптимизация использования ресурсов , помогающие предприятиям стать более продуктивными и надежными . Сегодня почти каждый бизнес пришел к выводу , что им необходимо начать автоматизировать некоторые из своих ручных бизнес - процессов . Автоматизация процессов снижает вероятность ошибок и может помочь компаниям стать более продуктивными и надежными . Клиенты пытаются максимально эффективно использовать свое оборудование , и иногда это означает , что им нужно выполнять больше работы , чем ресурсов . Планировщик заданий управляет очередями работ для поддержки сложных алгоритмов планирования , а также поддерживает и оптимизирует ограничения ресурсов наряду с рядом других преимуществ . Управление рабочей нагрузкой помогает вам более эффективно расставлять приоритеты задач , улучшать баланс работы в вашей команде и создавать более точные графики проектов . В результате у вашей команды есть потенциал и уверенность в выполнении качественной работы . Slurm Workload Manager — это современный планировщик с открытым исходным кодом , разработанный и поддерживаемый компанией SchedMD®. Slurm максимизирует пропускную способность , масштабируемость , надежность и приводит к максимально быстрому результату , оптимизируя использование ресурсов и отвечая организационным приоритетам . Автоматизируя планирование заданий , Slurm предназначен для удовлетворения высоких потребностей в высокопроизводительных вычислениях (HPC), высокопроизводительных вычислениях (HTC) и искусственном интеллекте . Возможности автоматизации Slurm упрощают администрирование , ускоряют выполнение заданий и повышают производительность конечных пользователей , одновременно снижая затраты и количество ошибок . Lenovo активно сотрудничает с SchedMD, чтобы предоставить клиентам правильное решение для планирования своих рабочих нагрузок и оптимизации своих ресурсов . Slurm полностью интегрирован в Lenovo Intelligent Computing Orchestration (LiCO), чтобы предоставить пользователям простой способ планировать свои рабочие нагрузки HPC и AI и оптимизировать их . Клиенты могут воспользоваться поддержкой L3 для Slurm в рамках предложения Lenovo HPC & AI Software Stack. Обзор Slurm Workload Manager Slurm Workload Manager — это ведущий на рынке бесплатный менеджер рабочих нагрузок с открытым исходным кодом , разработанный специально для удовлетворения высоких потребностей в высокопроизводительных вычислениях (HPC), вычислениях с высокой пропускной способностью (HTC , high throughput computing ) и искусственном интеллекте . Slurm максимизирует пропускную способность , масштабируемость , надежность и приводит к максимально быстрому результату , оптимизируя использование ресурсов и отвечая организационным приоритетам . Slurm отличается тем , как он управляет графическими процессорами . Пользователи могут планировать рабочие нагрузки для графических процессоров аналогично центральным процессорам , что обеспечивает большую гибкость и контроль над тем , как выполняется планирование . SchedMD является основной компанией Slurm, распространяющей и поддерживающей программное обеспечение диспетчера рабочей нагрузки . SchedMD является единственным поставщиком поддержки , разработки , обучения , установки и настройки Slurm. Slurm предоставляет три основных преимущества :

Возможности Slurm включают :

Пожалуйста , обратитесь к документации Slurm Workload Manager для получения дополнительной информации об этих возможностях Slurm. Клиенты выбирают и развертывают Slurm для :

Энергосбережение Slurm предоставляет встроенный механизм энергосбережения для отключения простаивающих узлов . Узлы , которые не используются в течение настраиваемого периода времени , могут быть переведены в режим энергосбережения , что снижает энергопотребление . Также доступен предел ограничения мощности для управления энергопотреблением . ExaScale Диспетчер рабочей нагрузки Slurm обеспечивает непревзойденную пропускную способность для большого количества рабочих мест и массивные ресурсы инфраструктуры HPC и искусственного интеллекта Lenovo для более быстрого предоставления инноваций и аналитических данных для конкурентного преимущества . Slurm предлагает широкие возможности масштабирования для работы с кластерами с более чем 100 000 узлов и графическими процессорами , что увеличивает пропускную способность в 5-10 раз . Возможности планирования и управления ресурсами Slurm легко справляются с обеими задачами , включая массивы заданий для отправки миллионов задач за миллисекунды и сверхдетализированное распределение задач по специализированным ресурсам ( ядрам , графическим процессорам , потокам и т . д .). Команда SchedMD точно настраивает конфигурации в соответствии с набором рабочих нагрузок и приоритетами , повышая при этом эффективность потребления ресурсов на 30–40 %. Дистрибутивы и документация по программному обеспечению Slurm Workload Manager доступен для загрузки в виде бесплатного программного обеспечения с открытым исходным кодом вместе с документацией и руководствами по установке на сайте https://slurm.schemd.com . Для получения информации о приобретении поддержки SchedMD Slurm Workload Manager Support обратитесь к торговому представителю Lenovo. Клиенты также могут получить доступ к дополнительным сведениям и информации об услугах поддержки SchedMD Slurm по адресу https://www.schedmd.com/services.php . Совместимость с операционной системой Slurm Workload Manager был тщательно протестирован на большинстве популярных дистрибутивов Linux. Некоторые функции ограничены последними выпусками и более новыми версиями ядра Linux. В настоящее время поддерживаются следующие дистрибутивы :

Интеграция со сторонним программным обеспечением Структура Slurm Workload Manager с открытым исходным кодом , лидерство , плагины и возможности REST API обеспечивают гибкую интеграцию с сотнями приложений для конечных пользователей HPC и AI, механизмов рабочих процессов и инструментов в различных вертикальных отраслях . См . https://slurm.schedmd.com/documentation.html для получения дополнительной информации . Аппаратная совместимость Slurm Workload Manager поддерживается на всех серверах Lenovo HPC/AI ThinkSystem. Глубокое погружение в Slurm Workload Manager Slurm — это современный планировщик , разработанный с архитектурой на основе подключаемых модулей , что позволяет ему поддерживать как большие , так и малые среды HPC, HTC и AI. Slurm обладает высокой масштабируемостью и надежностью , что обеспечивает максимально быстрое время вычислений среди всех планировщиков на рынке . Архитектура Slurm на основе подключаемых модулей позволяет загружать только те компоненты , которые необходимы для выполнения конкретных задач конечного пользователя . Эта легкая и гибкая структура обеспечивает большую оптимизацию и контроль при планировании операций . Slurm поддерживает сложности локальных , гибридных или облачных рабочих пространств . Плагины могут добавлять широкий спектр функций , включая управление ограничениями ресурсов и учет , а также поддержку расширенных алгоритмов планирования . Slurm поддерживает использование графических процессоров через концепцию общих ресурсов (GRES). GRES — это вычислительные ресурсы , связанные с узлом Slurm, которые можно выделить для заданий и шагов . Наиболее очевидным примером использования GRES могут быть графические процессоры . GRES идентифицируются по определенному имени и используют дополнительный подключаемый модуль для поддержки конкретных устройств . Основной файл конфигурации кластера Slurm, sl urm.conf, должен явно указывать , какие GRES доступны в кластере . Ниже приведен пример файла slurm.conf, который настраивает четыре графических процессора , поддерживающих многопроцессорную службу (MPS), с пропускной способностью сети 4 ГБ .

Кроме того , узлы Slurm, которым необходимо предоставлять GRES для заданий , должны иметь файл gres.conf. Этот файл описывает , какие типы общих ресурсов доступны на узле , их количество и какие файлы и процессорные ядра следует использовать с этими ресурсами . Когда это возможно , Slurm автоматически определяет графические процессоры в системе , используя библиотеку NVIDIA NVML. Библиотека NVML ( на которой работает инструмент nvidia-smi) нумерует графические процессоры в порядке их идентификаторов шины PCI. Файлы устройств графического процессора ( например , /dev/nvidia1) основаны на назначении младших номеров Linux , в то время как номера устройств NVML назначаются через идентификатор шины PCI, от самого низкого до самого высокого . Сопоставление между этими двумя значениями является недетерминированным и зависит от системы и может варьироваться в зависимости от загрузки после изменения оборудования или ОС . CUDA Multi-Process Service (MPS) предоставляет механизм , в котором GPU могут совместно использоваться несколькими заданиями , где каждому заданию выделяется определенный процент ресурсов GPU. Общее количество ресурсов MPS, доступных на узле , должно быть настроено в файле slurm.conf, например :

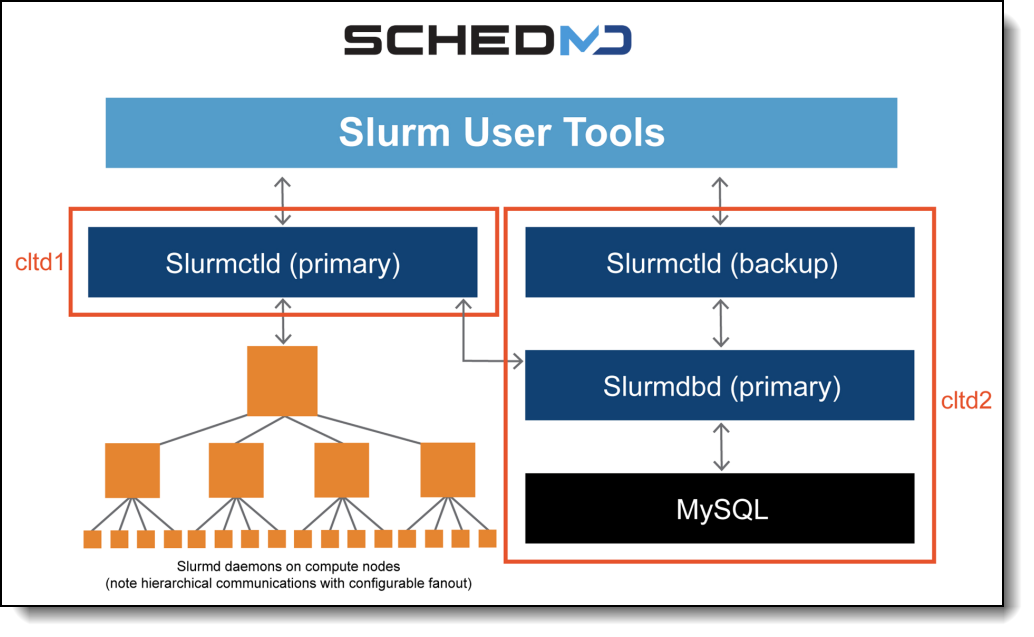

Запросы заданий для MPS будут обрабатываться так же , как и для любого другого GRES, за исключением того , что запрос должен быть удовлетворен с использованием только одного графического процессора на узел , и только один графический процессор на узел может быть настроен для использования с MPS. Например , запрос задания для --gres=mps:50 не будет удовлетворен при использовании 20 % одного графического процессора и 30 % второго графического процессора на одном узле . Несколько заданий от разных пользователей могут одновременно использовать MPS на узле . Обратите внимание , что GRES- типы GPU и MPS не могут быть запрошены в одном задании . Также задания , запрашивающие ресурсы MPS, не могут указывать частоту графического процессора . Качество обслуживания (QOS) Конечные пользователи могут указать качество обслуживания (QOS) для каждого задания , отправленного в Slurm. Правильная конфигурация качества обслуживания , связанного с заданием , гарантирует выполнение нужных заданий в нужное время . Slurm подавляет внутреннюю политику и конкурирующие рабочие нагрузки , помогая компаниям планировать конкурирующие потребности , достигая целей и поддерживая процессы . Архитектура SlurmНа следующем рисунке показаны компоненты архитектуры Slurm.

Рисунок 1. Компоненты Slurm Компоненты следующие :

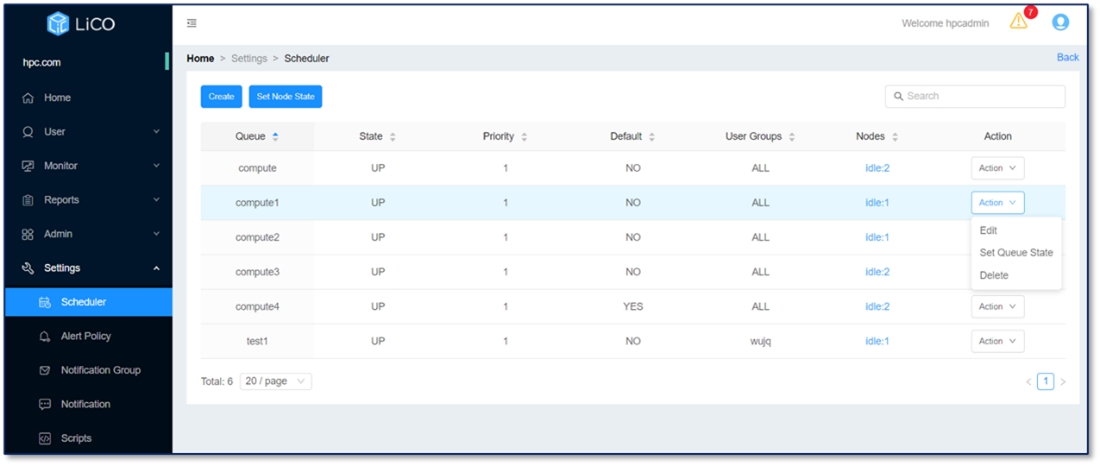

Управление рабочей нагрузкой Slurm для программного стека Lenovo HPC и AI Slurm является частью программного стека Lenovo для высокопроизводительных вычислений и искусственного интеллекта , интегрированного в качестве гибкого современного решения с открытым исходным кодом , обеспечивающего высокомасштабируемые , отказоустойчивые политики , алгоритмы и отчеты по управлению рабочими нагрузками . Программный стек Lenovo для высокопроизводительных вычислений и искусственного интеллекта представляет собой полностью протестированный и поддерживаемый , полный , но настраиваемый программный стек для высокопроизводительных вычислений , позволяющий администраторам и пользователям оптимально и экологически безопасно использовать свои суперкомпьютеры Lenovo. Программный стек был разработан , чтобы отвлечь пользователей от сложностей оркестрации кластера HPC и управления рабочими нагрузками ИИ , что делает программное обеспечение HPC с открытым исходным кодом доступным для каждого клиента . Вместе с Lenovo мы делаем преимущества Slurm еще более доступными благодаря интеграции с веб - порталом , которая позволяет вашим командам сосредоточиться на своей работе , пока Slurm управляет их рабочими нагрузками . Пользователи могут использовать Slurm без необходимости изучения команд или понимания сложности кластера , просто используя очень интуитивно понятный и простой в освоении интерфейс , который предоставит преимущества Slurm большему количеству клиентов и пользователей . Эти возможности позволяют клиентам Lenovo добиться более быстрой обработки заданий , оптимального использования специализированных системных ресурсов Lenovo и увеличения пропускной способности , что соответствует организационным приоритетам . Slurm обеспечивает оптимизированную производительность рабочих нагрузок для всех поддерживаемых Lenovo систем и серверов HPC/AI. Интеграция LiCO в Slurm Lenovo Intelligent Computing Orchestration (LiCO) — это программное решение , упрощающее использование кластерных вычислительных ресурсов для разработки и обучения моделей искусственного интеллекта ( ИИ ), а также рабочих нагрузок HPC. LiCO взаимодействует со стеком оркестрации программного обеспечения с открытым исходным кодом , обеспечивая конвергенцию ИИ в кластере высокопроизводительных вычислений . LiCO поддерживает Slurm Workload Manager в качестве планировщика для управления очередями , включая просмотр , создание и изменение очередей . Пользователи HPC и AI вводят свои данные ( скрипты , контейнеры , запрошенные ресурсы ) через интерфейс LiCO, а LiCO создает пакетный сценарий Slurm на основе входных данных для развертывания и управления рабочей нагрузкой . Версия Slurm, поддерживаемая в LiCO, — это версия последнего выпущенного пакета от Lenovo OpenHPC. Развертывание решения осуществляется с помощью LiCO GUI Installer. LiCO GUI Installer — это инструмент , упрощающий развертывание кластера H PC и настройку LiCO. Он работает на узле управления и может использовать Lenovo Confluent для развертывания ОС на вычислительных узлах . По окончании установки и LiCO, и Slurm будут установлены в кластере , указанном заказчиком в установщике . Главный узел Sl urm и узел управления LiCO должны быть развернуты на одном физическом узле в кластере . Управление рабочей нагрузкой с помощью LiCOОчереди позволяют администраторам подразделять оборудование на основе различных типов или потребностей . Slurm полностью интегрирован в LiCO, администраторы могут создавать и редактировать очереди прямо из LiCO, не заходя в планировщик Slurm напрямую через консоль . Это упрощает текущее управление корпоративными средами ИИ без опыта работы с программными инструментами для высокопроизводительных вычислений . Для роли администратора в LiCO доступна страница « Планировщик », которая позволяет администраторам создавать , редактировать , удалять очереди , устанавливать состояние очереди и устанавливать состояние узла .

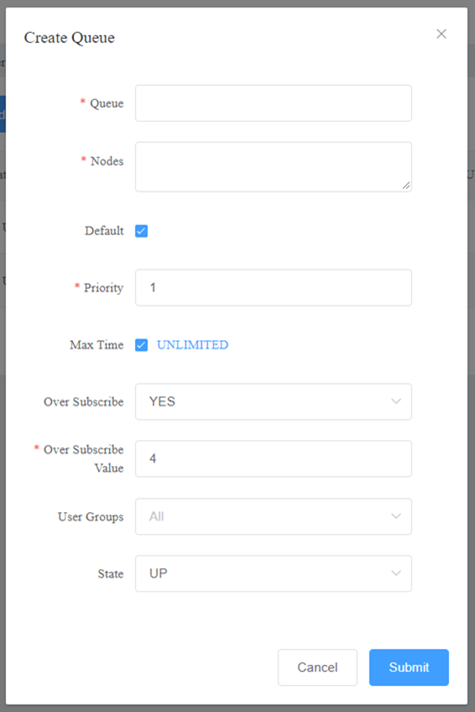

Рисунок 2. Страница управления планировщиком в LiCO Очереди позволяют администраторам подразделять оборудование на основе различных типов или потребностей . Создать очередь можно легко из интерфейса , что позволяет выполнять эту задачу даже пользователям , не знакомым с командной строкой . Интерфейс позволяет указать узлы , приоритет , максимальное время выполнения заданий , указать , могут ли вычислительные ресурсы ( отдельные ЦП ) в этой очереди совместно использоваться несколькими заданиями ( необязательный счетчик заданий указывает , сколько заданий может быть выделено для использования ). каждый ресурс ). Администраторы могут установить состояние очереди , указывающее , могут ли задания распределяться по узлам или ставиться в очередь в той же очереди . Для более опытных пользователей могут выполняться действия командной строки . В управлении очередями текущий пользователь может войти в головной узел и использовать командные строки планировщика Slurm. После завершения создания очереди и перезапуска сервисов , связанных со Slurm, вновь созданную очередь можно просмотреть в интерфейсе веб - портала . В последнее время очередь может быть изменена путем изменения файла конфигурации S lurm. На той же странице веб - портала пользователи могут редактировать , удалять , устанавливать состояние очереди и устанавливать состояние узла .

Рисунок 3. Создание очереди в LICO Качество обслуживания SlurmНекоторые клиенты , особенно клиенты кластера ИИ , раньше не использовали планировщик высокопроизводительных вычислений , но им необходимо ограничить использование вычислительных ресурсов для разных пользователей или групп . LiCO поддерживает сложную стратегию планирования с Slurm Quality of Service, чтобы помочь удовлетворить эту потребность . Качество обслуживания (QoS) — это метод , предоставляемый Slurm для определения правил ограничения вычислительных ресурсов кластера . Пользователи могут указать QOS для каждого задания , отправленного в Slurm. Администратор может динамически настраивать QoS с помощью команды Slurm, чтобы реализовать работу и обслуживание кластера . Чтобы правила QoS вступили в силу , необходимо установить отношения с очередями (Partition), группами пользователей (Account) и пользователями (User). Общие конфигурации QoS:

Примечание . Текущая версия LiCO не поддерживает настройку QoS Slurm через веб - интерфейс , что необходимо сделать через командную строку . Управление работой Управление заданиями может осуществляться через интерфейс LiCO. Администратор может просматривать и выполнять задания , давая команды планировщику . Примечание . Если задание отправлено через командную строку Slurm, оно не начнет выставление счетов в системе LiCO. Поддержка Slurm Workload Manager Хотя Slurm является менеджером рабочей нагрузки с открытым исходным кодом , внедрение передовых методов оптимизации расписания требует обучения и поддержки экспертов . Lenovo предоставляет поддержку и услуги в партнерстве с SchedMD. SchedMD является основной компанией Slurm, распространяющей и поддерживающей программное обеспечение диспетчера рабочей нагрузки . SchedMD также является единственным поставщиком поддержки , разработки , обучения и настройки Slurm. Защитите и улучшите свою среду Slurm с помощью SchedMD, чтобы ваше программное обеспечение не подвергалось риску и работало так , как вам нужно . Безопасность Лучший способ защитить вашу среду Slurm — это поддержка SchedMD. В случае нарушения безопасности конечные пользователи могут немедленно получить информацию об исправлениях от инженеров SchedMD. Lenovo обеспечит поддержку взаимодействия для всех программных инструментов , определенных как проверенные с помощью LiCO, включая Slurm. Ошибки / проблемы с открытым исходным кодом и поддерживаемыми поставщиками будут регистрироваться и отслеживаться с соответствующими сообществами или компаниями , если это необходимо , без каких - либо гарантий со стороны Lenovo в отношении исправления ошибок . Для поддержки программного обеспечения LiCO требуется подписка и поддержка , приобретаемые вместе с вашим решением . Для получения дополнительной информации обратитесь к торговому представителю Lenovo.

Техническая поддержка программного обеспечения означает предоставление Lenovo технической помощи по телефону или через Интернет техническим контактным лицам Заказчика в отношении любых дефектов программного обеспечения , ошибок и проблем с продуктом , проявляющихся в поддерживаемых конфигурациях Lenovo. Техническая поддержка не распространяется на помощь при первоначальной установке продукта , инструкции по использованию программного обеспечения , обучение и / или настройку производственной среды . Если вам нужна помощь в этих областях , обратитесь к торговому представителю Lenovo или бизнес - партнеру Lenovo, чтобы получить наилучшие предложения по обслуживанию . Служба поддержки LenovoЧтобы связаться со службой поддержки Lenovo:

Дополнительные сведения и дополнительную информацию о поддерживаемых компонентах см . на странице https://support.lenovo.com/us/en/solutions/HT507011 . SchedMD является основным разработчиком и поставщиком услуг для Slur m, предоставляя услуги поддержки , консультирования , настройки , разработки и обучения для ускорения результатов рабочей нагрузки с помощью проверенных передовых методов и инноваций . SchedMD предлагает в 5-10 раз более сложные возможности планирования высокопроизводительных вычислений и искусственного интеллекта , включая половину самых больших систем в TOP500, для оптимизации скорости , пропускной способности и использования ресурсов для каждого уникального сочетания рабочих нагрузок , чтобы организации могли быстрее и проще получать больше результатов . Экспертные услуги SchedMD позволяют организациям быстро внедрять , максимизировать пропускную способность , управлять сложностью и легко наращивать свои высокопроизводительные рабочие нагрузки на решениях Lenovo HP C и AI. Клиенты добавляют поддержку SchedMD Slurm для : Поддержка SchedMD Slurm для систем Lenovo HPC Поддержка и услуги Slurm являются частью стека программного обеспечения Lenovo для высокопроизводительных вычислений и искусственного интеллекта , интегрированного в виде гибкого и современного решения с открытым исходным кодом для управления сложными рабочими нагрузками для более быстрой обработки и оптимального использования необходимых крупномасштабных и специализированных высокопроизводительных ресурсов и ресурсов искусственного интеллекта . за рабочую нагрузку , предоставляемую системами Lenovo. Возможности службы поддержки SchedMD Slurm для систем Lenovo HPC включают : • Поддержка уровня 3. Высокопроизводительные системы должны работать с высокой степенью использования и производительности , чтобы обеспечить конечным пользователям и руководству окупаемость инвестиций . Клиенты , охваченные контрактом на поддержку , могут обратиться к экспертам SchedMD Slurm, чтобы помочь решить сложные проблемы и вопросы управления рабочими нагрузками быстрее , включая подробные ответы непосредственно от команды разработчиков Slurm, вместо того , чтобы тратить недели или даже месяцы на их решение своими силами . • Помощь в настройке : ценная помощь , когда клиентская система изначально настраивается для использования Slurm или модифицируется по мере изменения требований . Клиенты могут просмотреть требования к кластеру , операционную среду и организационные цели с помощью инженера Slurm, который будет работать с ними над оптимизацией конфигурации для достижения их потребностей . • Индивидуальное обучение Slurm: SchedMD может предоставить индивидуальное обучение Slurm для клиентов Lenovo, которые в этом нуждаются или желают . Представители или клиенты Lenovo могут связаться со Стюартом Райтом по адресу SchedMD, stuart@schedmd.com , чтобы запросить стоимость обучения . Предварительный звонок клиента перед удаленным обучением или обучением на месте обеспечивает охват их конкретных вариантов использования и потребностей в углубленном и всестороннем техническом обучении Slurm, проводимом в формате практического лабораторного семинара , чтобы пользователи могли также ознакомиться с передовыми методами Slurm. как варианты использования для конкретных сайтов и оптимизация конфигурации . Для дополнительной информацииЧтобы узнать больше об оркестровке вычислений Lenovo и Slurm, воспользуйтесь следующими ссылками или обратитесь к торговому представителю или бизнес - партнеру Lenovo: Авторы Ана Иримиа (Ana Irimiea) — менеджер по продукции Lenovo AI Systems & Solutions. Она определяет маркетинговые требования и участвует в процессе выполнения операций для каждого выпуска решения , чтобы возглавить следующее поколение платформ и решений для ИИ и высокопроизводительных вычислений . Она является менеджером по продуктам серверов Lenovo с мощными графическими процессорами и программным стеком HPC&AI. В настоящее время Ана живет в Бухаресте , Румыния , и имеет степень бакалавра системной инженерии и магистра управления в области информационных технологий , полученную в Политехническом университете Бухареста . Виктория Хобсон — вице - президент по маркетингу компании SchedMD. Она устанавливает видение и развитие бренда , одновременно поддерживая маркетинговую деятельность в компании . Имея опыт работы в области маркетинга программного обеспечения и специализируясь на партнерских отношениях , Виктория возглавляет маркетинговые отношения между SchedMD и Lenovo. В настоящее время Виктория живет в Гринвилле , Южная Каролина , и имеет степень бакалавра в области медиакоммуникаций со степенью бакалавра в области международного бизнеса Университета Бригама Янга . Связанные семейства продуктов Семейства продуктов , относящиеся к этому документу , следующие : Товарные знаки Lenovo и логотип Lenovo являются товарными знаками или зарегистрированными товарными знаками Lenovo в США и / или других странах . Текущий список товарных знаков Lenovo доступен в Интернете по адресу https://www.lenovo.com/us/en/legal/copytrade/ . Следующие термины являются товарными знаками Lenovo в США и / или других странах : Lenovo® , ThinkSystem® Следующие термины являются товарными знаками других компаний : Linux® является товарным знаком Линуса Торвальдса в США и других странах . Другие названия компаний , продуктов или услуг могут быть товарными знаками или знаками обслуживания других лиц . |

| ||||||||||